Quel rôle jouent les algorithmes de recommandation dans notre écosystème informationnel ?

Les algorithmes de recommandation façonnent la présentation de l’information sur beaucoup de réseaux sociaux : quels rôles jouent-ils dans la propagation de la désinformation, la création de bulles d’information ? Dans quelle mesure influencent-ils les opinions des utilisateurs ?

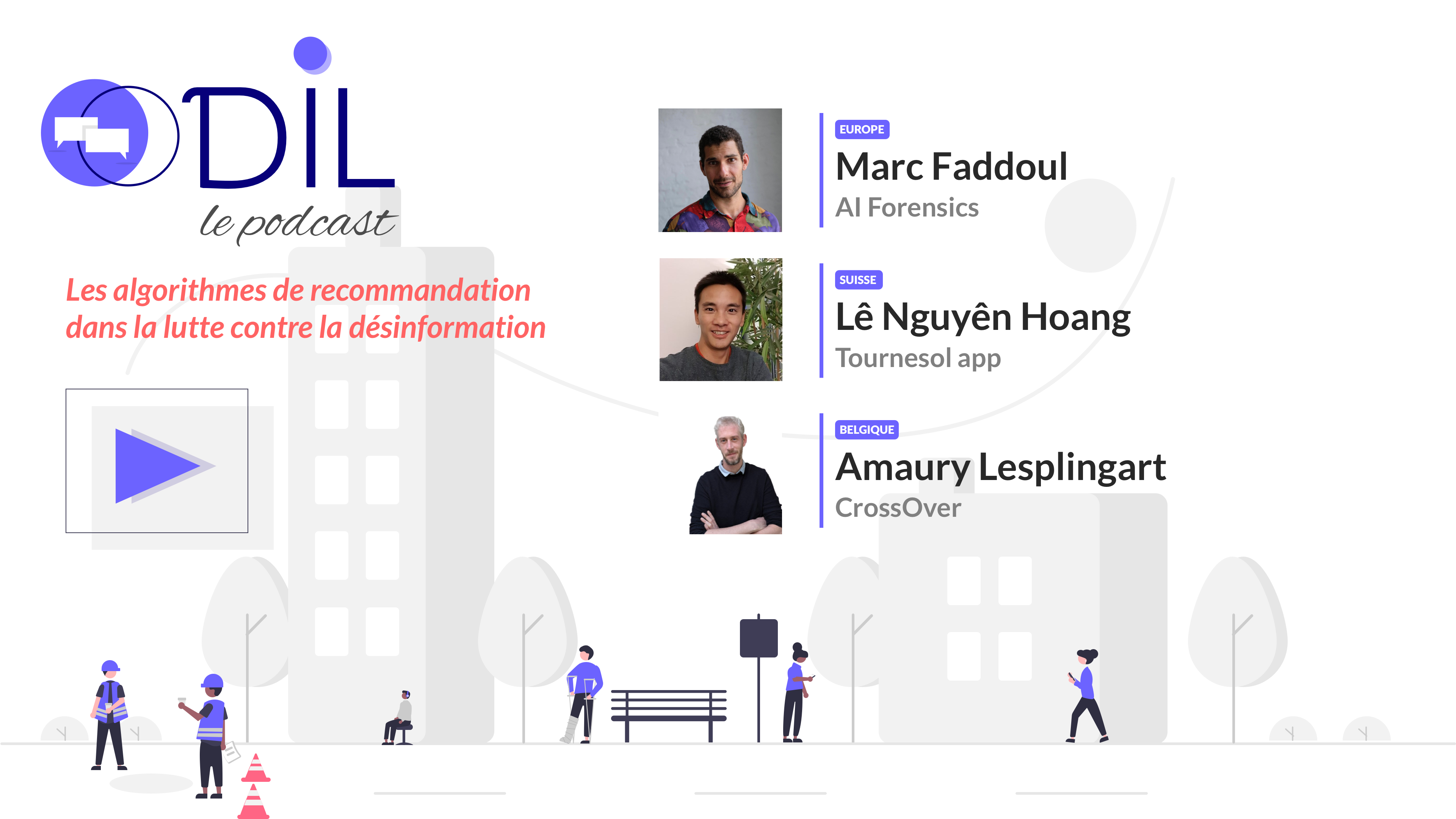

Odil s’est entretenu avec Marc Faddoul, directeur d’AI Forensics (Europe), Amaury Lesplingart, co-fondateur et directeur technique de CheckFirst pour le projet Crossover (Belgique)et Lê Nguyên Hoang, co-fondateur de Tournesol (Suisse) pour tenter de répondre à ces questions.

Les algorithmes de recommandation jouent un rôle clé dans la manière dont nous consommons l’information en ligne. Ils influencent les contenus qui nous sont présentés, façonnant ainsi nos perspectives et nos interactions avec le monde numérique.

Aujourd’hui, il convient de rappeler, comme Marc Faddoul l’explique, que les algorithmes sont essentiellement basés sur leur métrique d’optimisation : l’une des métriques commune à toutes les plateformes, c’est l’engagement et la maximisation de l’engagement. Cette métrique a tendance à pousser du contenu plus polarisant et sensationnaliste et l’utilisateur ne peut pas choisir. Marc prend l’exemple de Tiktok : la page For You, celle qui est la plus utilisée dans le réseau, montre très peu de contenu qui provient des abonnements.

On observe d’ailleurs des influenceurs demandant à leur communauté simplement de « regarder 5x une vidéo » ou « juste cliquer sur partager sans l’envoyer à personne » pour augmenter leur potentiel de visibilité dans les feed.

Et ce n’est pas nouveau. Amaury Lesplingart explique aussi la façon dont le fait de dévoiler l’algorithme de Twitter a permis de comprendre à quel point les utilisateurs étaient incités à rester sur la plateforme : par exemple, publier un lien externe (incitant à sortir du site donc) est déprécié en termes de visibilité par rapport à la publication d’une image ou d’un thread.

Toutefois, cette amplification algorithmique peut également conduire à une diffusion accrue de contenus problématiques, tels que la désinformation, les contenus extrémistes ou les théories du complot.

Amaury Lesplingart le souligne: le projet CrossOver a notamment permis de démontrer comment Donbas Insider, un média pro-kremlin a été mis en avant par l’algorithme de Google News quand les utilisateurs tapaient le mot-clé « Donbas » en Belgique dans la barre de recherche.

Les algorithmes peuvent aussi être utilisés par les puissances « pour asseoir son soft power » : il relate le cas la Chine, par exemple, dont les médias d’État ont produit pléthore d’articles pour décrire à quel point le XinJiang était une province grande et belle et merveilleuse alors que sortait dans le même temps un rapport d’Amnesty International sur les conditions de la population ouïgour précisément dans cette provinces.

La question de l’intention

Accident industriel ou intérêt dissimulé ? La question de l’intentionnalité derrière ces amplifications algorithmiques est intéressante. Marc Faddoul préfère reprendre l’expression d’un « incident industriel ». Selon lui, si les tentatives d’ingérence ne sont pas à exclure, il semble que ce soit davantage le design algorithmiques associé aux biais cognitifs des usagers qui vont chercher inconsciemment du contenu sensationnaliste, et à des acteurs externes qui essaient d’exploiter les failles du système ne faisant de l’optimisation de référencement sur Google, qui sont responsables de ce genre de recommendation.

Sur la question de l’IA « il est pertinent de regarder ce qu’il se passe au niveau des IA génératives pour comprendre ce qu’il va se passer sur les réseaux sociaux dans le futur ».

« Le danger ne vient pas de l’IA en elle-même […] mais de l’usage que les humains vont faire de ces nouvelles technologies »

Marc Faddoul, AI Forensics

Redonner le pouvoir des algorithmes aux utilisateurs, une utopie ?

Face aux risques que représente le caractère parfois hasardeux des recommandations algorithmiques, Lê Nguyên Hoang a pris le taureau par les cornes. Tournesol.app devance les algorithmes proposés par les plateformes. « Ce choix de quel contenu montrer est fait de manière unilatérale par des entreprises privées avec très peu de contrôle démocratique ». Il souligne, lui aussi, le potentiel dangereux des informations proposées.

Le coeur de Tournesol ? Proposer des informations de manière plus démocratique par un système de vote. Les utilisateurs sont invités à voter pour des contenus qu’il aimeraient voir plus ou moins recommandés. Grâce à des extensions de navigateur, les utilisateurs de l’app peuvent voir les recommandations selon l’algorithme de Tournesol directement sur la page d’accueil du réseau social concerné, le tout encadré par un système de sécurité sérieux. L’idée est aussi de motiver la recherche académique sur ce sujet.

Le système de Tournesol place l’utilisateur au centre de ses choix algorithmiques.

Vers une souveraineté algorithmique ?

Alors comment faire pour redonner davantage de contrôle à l’utilisateur, pour que celui-ci puisse choisir ce qu’il consulte ? Deux solutions : il peut choisir l’algorithme qu’il veut utiliser. C’est l’approche de Tournesol, une interopérabilité adversariale : injecter par-dessus l’algorithme existant, sans demander l’aval des plateformes, ce qui permet de faire évoluer les choses plus rapidement.

L’autre solution est de personnaliser un algorithme déjà existant en demandant à la plateforme de présenter un certain type de contenu.

Quelles solutions ?

Renforcer les régulateurs, utiliser les lois en place

Il ne s’agit pas d’empêcher les personnes de faire des choses sur internet mais bien qu’ils prennent leur responsabilité, dans un premier temps en appliquant les lois existantes « Quand la Commission Européenne réussit à faire condamner un GAFAM, l’amende est dérisoire par rapport à leur Chiffre d’Affaire. Ainsi soit-il, ils paient et voilà ». Le projet Crossover porte ce message qu’il ne veut pas voir ce qu’il y a dans la fameuse black box, mais comprendre le résultat affiché aux utilisateurs et que Google prenne la responsabilité de ce problème et mette en place des mesures pour que ce problème n’arrive plus à l’avenir.

Éduquer, éduquer, éduquer

Et puis l’Éducation aux Médias et à l’Information aussi, toujours, qui revient jusqu’alors dans toutes les suggestions évoquées dans tous les épisodes de ce podcast. Logique puisque les jeunes générations sont exposées tôt à ce genre de contenu notamment via TikTok. L’EMI permet aussi de se méfier de la désinformation qui circule également sur les messageries sécurisées, moins régulées que les plateformes.

Promouvoir l’information de qualité

Enfin, changer de paradigme afin de promouvoir l’information de qualité, comme le propose Marc Faddoul. « Je pense qu’aujourd’hui on investit l’énergie humaine là où l’intelligence artificielle entre guillemets est assez limite et notamment dans la modération de contenu. […]

Là où j’aime beaucoup l’approche de Tournesol c’est qu’en fait on inverse le problème en disant au lieu de se concentrer sur arrêter de promouvoir ou de bloquer de l’information de mauvaise qualité est-ce qu’on peut pas plutôt se concentrer sur comment promouvoir de l’information de bonne qualité. Et je pense que c’est un paradigme complètement différent mais qui fait plus sens.

[…] les gens qui cherchent de l’information de mauvaise qualité et qui cherchent de la désinformation parce qu’ils cherchent à renforcer des opinions qu’ils ont déjà, ils vont dans tous les cas trouver cette information. Pour moi c’est pas forcément la bonne bataille. La bonne bataille c’est comment est-ce qu’on peut promouvoir de l’information de qualité et aux gens qui n’ont rien demandé. En fait c’est sur les recommandations par défaut qu’il faut travailler. »

Vous aussi, inscrivez votre initiative!

Rejoignez les membres de l’ODIL et l'opportunité de prendre connaissance des autres initiatives de vérification et pourquoi pas de nouer de nouveaux liens !

En savoir plus